Por Felipe da Silva Santos, Criado em 28/11/2023

Em um mundo cada vez mais digital, videochamadas se tornam o normal no dia a dia. No entanto, extrair informações importantes dessas reuniões pode ser uma tarefa maçante, muitas vezes obrigando a revisão de gravações ou tomada de notas durante a reunião. Ainda assim, registrar pontos-chave discutidos e os próximos passos definidos é crucial para a continuidade dos projetos e a eficiência organizacional, tornando-a uma etapa obrigatória.

Com o avanço das tecnologias de IA, especificamente dos Grandes Modelos de Linguagem (LLM) como o GPT-4, novas possibilidades surgiram na tratativa e extração de informações em dados não estruturados. Tais ferramentas permitem a criação de soluções inovadoras para problemas complexos, onde métodos e tecnologias convencionais não conseguem ser efetivas.

Diante desse cenário, as inovações trazidas pelos Grandes Modelos de Linguagem, se apresentam como ferramentas valiosas. Elas permitem a transformação de dados não estruturados gerados em videochamadas em insights acionáveis e registros organizados, pavimentando assim o caminho para uma gestão de informações mais eficaz e automatizada.

Introdução à Solução

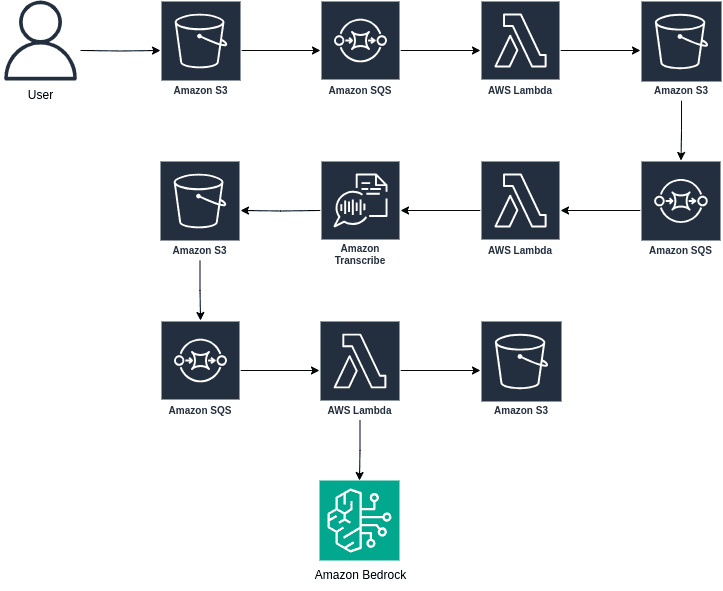

A proposta de solução para o problema utiliza uma arquitetura serverless com os serviços da AWS. A solução segue o seguinte fluxo:

-

Ao subir um vídeo no Amazon S3, uma Lambda é ativada pelo Event Notification do Bucket

-

A função extrai o áudio do vídeo e salva o arquivo em outra pasta do Bucket.

-

Este arquivo dispara um Event Notification para outra Lambda.

-

O Lambda cria um job no Amazon Transcribe.

-

O resultado do job é enviado para o Bucket.

-

Um Lambda é disparado pelo resultado do job, ela aplica algumas tratativas e envia o texto com um prompt para a API do Amazon Bedrock, o prompt é escrito com o objetivo de extrair os principais pontos discutidos na reunião, e se houver, quais foram os próximos passos definidos.

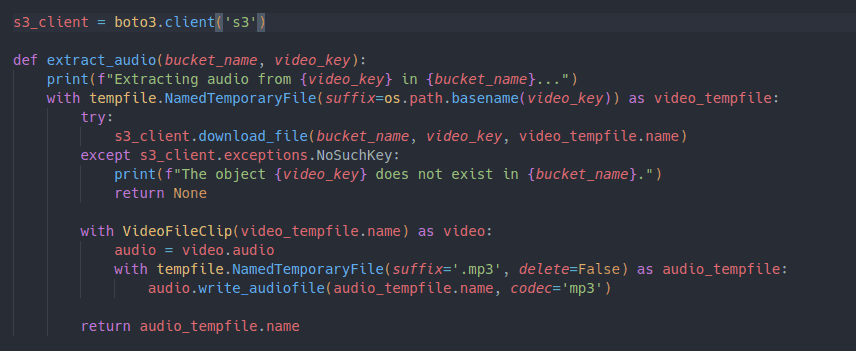

Extração do Áudio

O primeiro passo para automatizar a extração das informações de uma videochamada é obter o áudio do vídeo. Este processo se inicia com um Event Notification, de forma que, ao carregar um vídeo no Bucket S3, uma função Lambda é disparada.

Então a função Lambda faz o uso de uma biblioteca do python para extrair o áudio do vídeo. Uma vez extraído, o áudio é armazenado no mesmo Bucket S3, porém em uma pasta diferente, a fim de manter uma organização clara dos dados.

Este novo arquivo de áudio aciona a próxima etapa do processo: a execução de um job no Amazon Transcribe. É aqui que o áudio será transcrito para texto, possibilitando a extração e análise das informações de uma videochamada por um LLM.

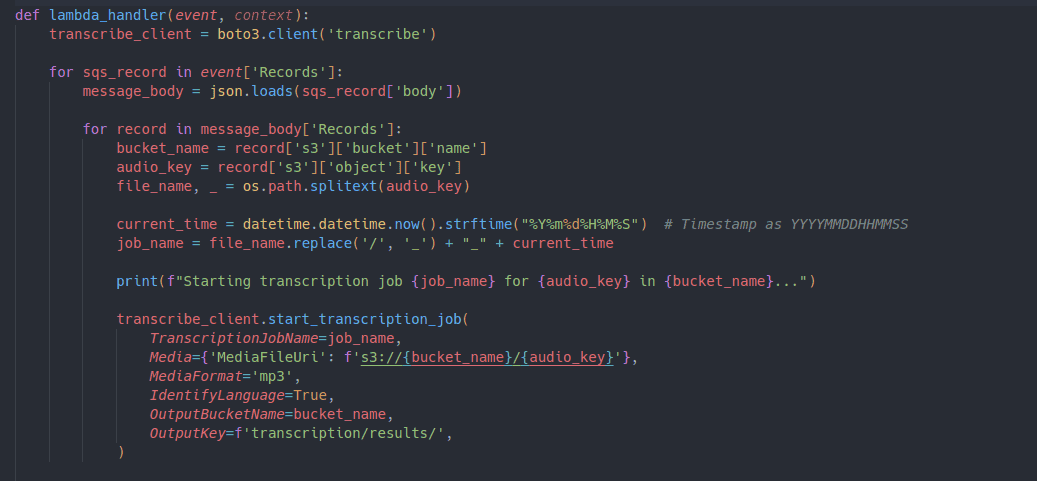

Executar um Job no Transcribe

O Amazon Transcribe é uma ferramenta poderosa de conversão de fala em texto, projetada para simplificar o processo de transcrição de áudio. Este serviço utiliza o conceito de jobs, que são configurações específicas para processar os arquivos de áudio desejados.

Ao criar um job no Amazon Transcribe, o usuário precisa fornecer informações essenciais, como a localização do arquivo de áudio, o idioma falado no áudio e, se necessário, pode também utilizar um vocabulário personalizado para garantir a precisão da transcrição, especialmente em casos que envolvem termos técnicos ou jargões específicos.

O processo de transcrição propriamente dito é iniciado quando o job é acionado. Nesse momento, o arquivo de áudio é submetido ao sistema, que utiliza algoritmos avançados de reconhecimento de fala para converter a fala em texto. Ao finalizar o job, o resultado é um arquivo em formato JSON que contém não apenas a transcrição textual, mas também informações adicionais como a confiança na precisão da transcrição (indicando o quão confiável é o texto transcrito) e a marcação de tempo de cada palavra.

Após a conclusão do processo de transcrição, o próximo passo é a utilização do Amazon Bedrock. O Amazon Bedrock desempenha um papel essencial na continuação do processo. Uma vez que o texto tenha sido transcrito, é hora de extrair insights e realizar análises mais profundas.

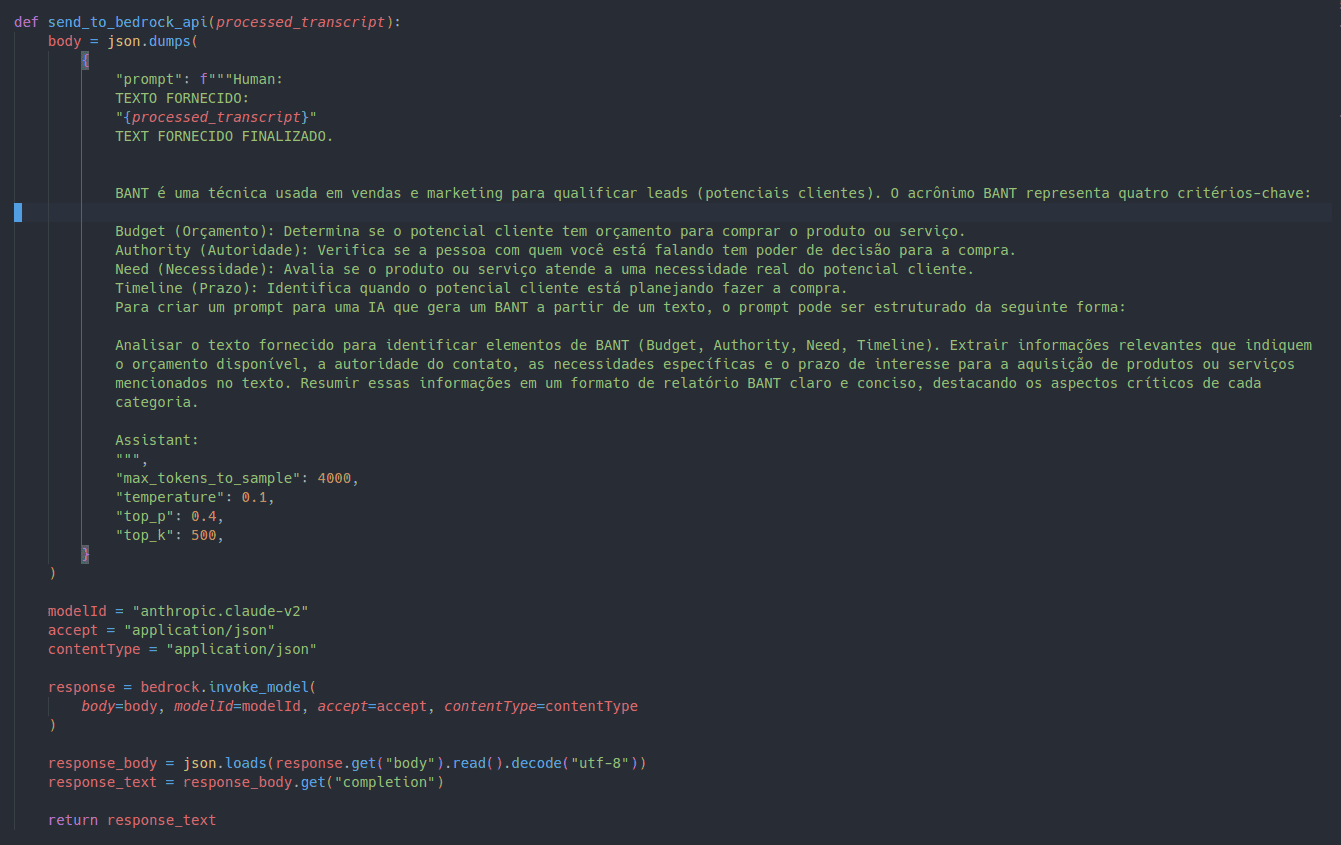

Utilização do Amazon Bedrock

Com o texto transcrito pelo Amazon Transcribe em mãos, o fluxo segue com um novo Event Notification que ativa uma Lambda, que realiza uma chamada à API do Amazon Bedrock. Este serviço gerenciado da AWS facilita a criação e o escalonamento de aplicações de IA generativa utilizando modelos de base. Oferece diversas escolhas de modelos de várias organizações líderes de IA, permitindo atualizações com poucas mudanças de código.

O Amazon Bedrock permite a customização fácil de modelos com dados próprios sem necessidade de programação. Pode construir agentes gerenciados que invocam APIs para realizar tarefas complexas, também possui suporte nativo para Geração com Augmentação de Recuperação (RAG) para conectar modelos a bases de dados proprietárias, garantindo a segurança de dados e conformidade com normas como HIPAA e GDPR.

O modelo escolhido para a solução é o Claude 2.0, que é um modelo de linguagem de grande escala, com uma impressionante janela de contexto de 100K tokens, o que permite uma análise detalhada de grandes blocos de texto. Sua habilidade de processar e entender contextos complexos faz dele uma ferramenta valiosa na extra�ção de informações críticas a partir do texto transcrito.

No core do Bedrock, o Claude 2.0 é acionado com um prompt pré-definido, que orienta o modelo sobre o que procurar no texto transcrito. Este prompt pode ser configurado para identificar e extrair pontos-chave discutidos e as ações futuras definidas durante a reunião, proporcionando uma visão clara e concisa do conteúdo discutido.

Os Modelos de Linguagem de Grande Escala (LLM) como o Claude 2.0 são conhecidos por sua versatilidade e capacidade de adaptar-se a uma variedade de tarefas de processamento de linguagem natural. Esta flexibilidade torna o Amazon Bedrock uma plataforma robusta e adaptável para lidar com os desafios de análise de texto, possibilitando transformar transcrições de reuniões em insights acionáveis de forma eficaz e eficiente.

Ao utilizar o Amazon Bedrock, as organizações não apenas conseguem automatizar a extração de informações de reuniões, mas também ampliam suas capacidades de análise de texto, permitindo uma análise mais profunda e contextualizada de dados não estruturados.

Conclusão

A solução proposta oferece um sistema totalmente serverless que alivia uma dor de negócios significativa, automatizando a extração de informações de reuniões gravadas. Além disso, integra-se harmoniosamente com os serviços AWS, proporcionando uma implementação simplificada e uma operação eficiente. Ao alavancar o poder do Amazon Bedrock e dos Modelos de Linguagem de Grande Escala, as organizações podem agora transformar suas videoconferências em insights acionáveis, impulsionando assim a produtividade e a tomada de decisão informada.